Voici la troisième partie et, après regroupement de tous les textes, le seul article nécessaire et suffisant pour découvrir cette présentation de l’ouvrage édité par les éditions Prosper Assouline consacrée à «l’esprit Serge Lutens». Malgré le travail fastidieux, voire harassant qui consiste à photographier un livre aussi important, avec une double approche, celui du documentaliste respectueux de ce qui est, et celui du guide artistique qui ne peut s’empêcher de s’approcher, recadrer, attirer votre regard sur tel ou tel détail , je ne me suis lassé à aucun moment tant son travail me fascine et à bien des égards! Je vous rappelle ici le contexte. J’avais cet ouvrage dans ma bibliothèque depuis sa publication. J’y ai personnellement et très modestement contribué en numérisant la police de caractère qui compose les textes de l’album. Et puis je le re-découvre, et me dit que si Design et Typo ne publie pas les belles pages de ce livre, il finira oublié du plus grand nombre parce qu’épuisé et sans doute sans intention d’être réédité. J’appelle l’éditeur qui très gentiment me renvoie avec son accord de principe sur l’auteur, Serge Lutens. «il faut bien entendu que vous ayez son accord aussi…» Après deux trois coups de fil je conviens avec Patrice Nagel, le complice, assistant et ami de Serge d’un rendez-vous parisien où Monsieur Lutens pourra nous commenter son travail. L’hôtel Ritz servit de cadre à cet interview, lieu de luxe raffiné sans doute, mais n’est-ce pas aussi le métier de Serge Lutens que de voyager dans le monde de la Mode et du Luxe. Jean-Charles Baudot m’accompagna pour la prise de son ainsi qu’Anne Maigret pour les portraits magnifiques qu’elle réalisa durant l’interview.

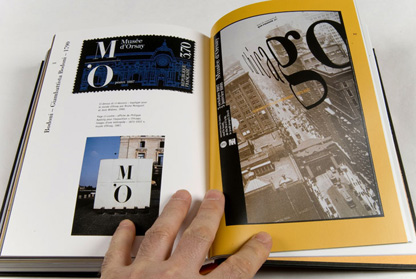

Le spectacle de ce livre nécessiterait plutôt les moyens d’une video où l’on pourrait s’approcher en mouvement, faire des travelling, s’éloigner pour avoir une vision d’ensemble… j’ai utilisé ici la photographie pour tenter de montrer les constantes créatives de S.L. D’abord l’architecture, la vue d’ensemble de chaque page montre à souhait la nécessité où se trouve l’artiste de structurer l’espace, le corps, les vêtements, le maquillage et les accessoires. En ce sens c’est un ouvrage pédagogique en soi qui nous explique ce que c’est que la mode. Une sublimation du paraître par l’être. S.L. nous conduit sur un chemin difficile, visuellement et intellectuellement.

Car enfin la Mode, tant décriée par les détracteurs d’une société de consommation, représente pour beaucoup sinon l’inaccessible en tous cas le superflu cher. Il faut avoir lu les textes de Barthes dans le Système de la Mode, pour se convaincre qu’il s’agit non seulement de photographies de mannequin, de prises de vues de l’inutile mais aussi d’une industrie toute entière consacrée à l’élaboration d’un système en permanente évolution. La Mode est nécessaire aussi bien pour les boutiquiers du Sentier que pour notre inconscient collectif, elle fonctionne certes sur les référents: «dimanche après-midi, vous porterez un tweed croisé sur les champs de courses», mais nous permet aussi de rythmer le temps social, de découper celle-ci en séquences donnant à la perception de notre monde complexe une lisibilité visuelle et sociale des plus précise.

Serge Lutens a poussé, en exagérant chaque composante de la photographie de mode jusqu’à l’extrême. L’architecture du corps et des vêtements, se dé-structure pour notre plus grand plaisir pour se restructurer en événement spectaculaire. Le corps n’est plus, pas plus que le vêtement, seule reste une composition picturale dont la moindre des qualités est justement de nous faire oublier qu’il ne s’agit que… de Mode. Parce que pour Serge Lutens, même s’il s’en défend, il s’agit probablement de religion bien plus que de photographie de Mode. Il suffit de regarder ses compositions pour s’en convaincre. J’ai voulu systématiquement montrer chacune de ses créations en trois temps ou plus. Vue d’ensemble, plein cadre sur les visages, plan resserré sur les mains, et parfois pas toujours, une série de détails sur les accessoires. Que constatez-vous. Les mains tout d’abord, elles ne servent que pour désigner, ou éventuellement s’affleurer, le geste du maquillage, une caresse à peine, ébauche d’un geste éternel que les femmes vivent depuis la nuit des temps. Justement les femmes, ou La Femme qui n’existe pas pour Lacan, car elles sont toutes une et inversement, sont assexuées , postures religieuses qui nous rappellent des tableaux du moyen âge ou plus près de nous un Chagall ou un Kandinsky. Des bas reliefs des églises aux tryptiques orthodoxes russes, ces femmes ne s’habillent pas, elles sont habillés par vocation de beauté où le spirituel le dispute au religieux. Elles incarnent la Beauté venue sur Terre voici quelques millions d’années autant dire une éternité.

Serge Lutens aime les Femmes pour le message de beauté qu’elles délivrent, mais ce faisant il les re-construit avec minutie, sachant o combien le hasard ne peut répondre seul à la question lancinante du qu’est-ce qui est beau ou pas. Il les re-structure pour leur permettre de se libérer de toute structure et archaïsmes qui les a rendu esclaves d’elles-même avant d’être des esclaves de la Mode. C’est en photographiant chaque détail de l’œuvre de Lutens que je découvre la simple complexité d’une pensée toute entière tournée vers le magistral. Car Serge Lutens est un pédagogue, il ne montre pas seulement, il nous explique, il donne à voir les secrets de son art. Structure après structure, il nous administre les vérités du rythme, des espaces, des lignes de fuite, des obliques et des parallèles. Ce que les peintres ont peint durant les années 20 il le fait revivre pour donner du sens aux sens. Au travers de ces photographies, on comprend mieux le Bauhaus, et le constructivisme des années 20, on entre en religion du surréalisme parce que les femmes de S.Lutens incarnent, figures vivantes, l’art contemporain, le questionnement permanent… Suis-je belle, suis-je la plus belle? oui, non, tu es• La Femme, épicentre du futur et de l’avenir, celle par qui les lignes de fuite font sens et pour qui les hommes se sont damnés pour l’éternité.

Serge Lutens nous administre une leçon de choses de la vie, par les courants ascendants de l’art premier qu’il a découvert bien avant que le quai Branly se mette en mouvement, les «roots» qu’il n’a cessé d’aller puiser dans la civilisation japonaise ou marocaine. S’agit-il d’un grand écart ou bien d’une logique qui allie la perfection nippone, ce goût pour le parfaitement ajusté à l’esprit décoratif et ludique de l’islam qui prône le plaisir comme une religion du ici et maintenant. Religion et perfection sont les constantes de l’art de Serge Lutens.

cliquez sur l’animation pour accéder à la Galerie d’étude de l’ouvrage «L’Esprit Serge Lutens»

Rappel: L’ouvrage de Serge Lutens est épuisé, Design et Typo a obtenu la permission de le publier in-extenso avec toutefois l’indication suivante: toute reproduction est interdite, usage strictement pédagogique. Un grand merci à l’éditeur, à Serge Lutens et Patrice Nagel sans qui ce billet n’aurait pu être publié.

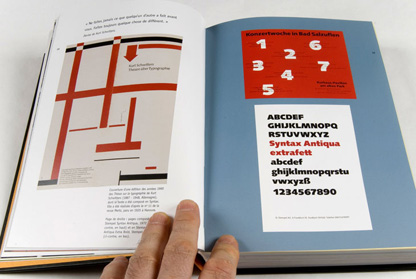

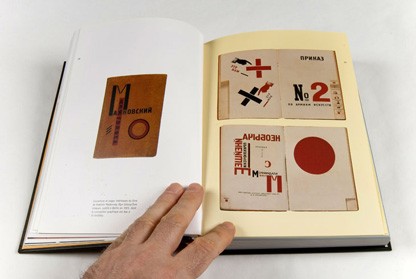

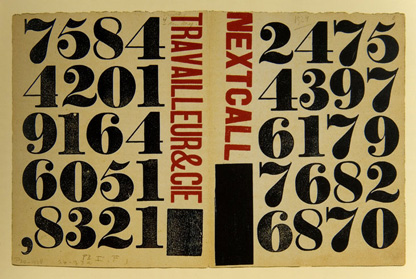

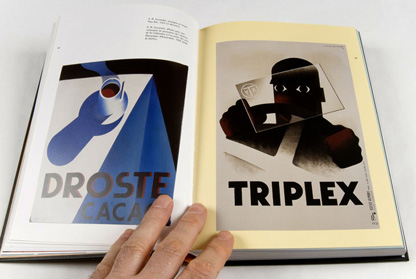

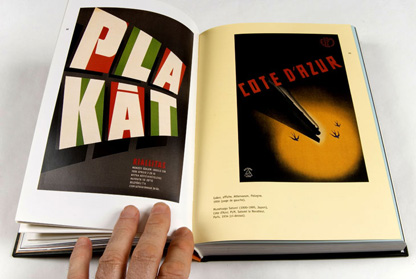

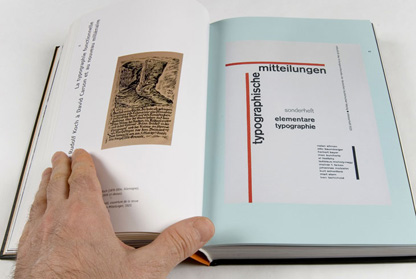

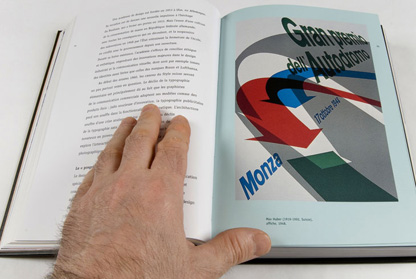

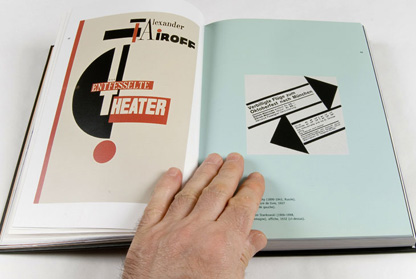

J’ai évoqué ci-dessus la relation intime de l’œuvre à la structure (constructivisme russe, Bauhaus, surréalisme). D’aucuns diront que S.Lutens n’a fait qu’une œuvre de copie de ces esthétiques du début du siècle, mais l’a-t-on dit de Neville Brody lorsqu’il mit en Page la revue The Face, ou bien de Philippe Starck qui selon moi et indépendamment de toute considération affective a eu le mérite de faire enfin découvir les recherches architecturales et graphiques des années 20-30 qui furent menées en Allemagne d’avant guerre. Non et heureusement. Parce qu’en tout état de cause il ne s’agit aucunement de copie. Plutôt de l’adoption d’un vocabulaire, d’une grammaire graphique pour mettre en scène le travail de Lutens sur le textile, le maquillage, la sculpture, les bijoux. Œuvre chargé s’il en fut par les innombrables références dont la moindre n’est pas le Moyen Âge qui revient régulièrement de façon lancinante dans le travail de l’artiste. Car au fond Serge Lutens nous fait tout d’abord voyager, dans le temps et l’espace. De la période Grecque d’Aristote au Romantisme de Chateaubriand et Gustave Flaubert en passant bien entendu par le Haut Moyen Âge qui fut une des périodes les plus libertines pour le vêtement et la représentation du corps. il n’oublie bien sûr pas le passage au siècle de l’automobile où l’on découvre les belles de la Période dite Belle, justement, les années folles. La trame de l’ouvrage, est le texte, éternel fil d’Ariane qui donne du sens à toutes ces représentations visuelles en n’oubliant ni de parler de la musique, ni des sculptures, ni de la Mode. Du voyage dans le Temps, S.Lutens passe à celui de l’espace en nous faisant découvrir l’extrême orient avec le Japon et les terres maghrebines en pénétrant plus profondément dans Afrique des ancètres.

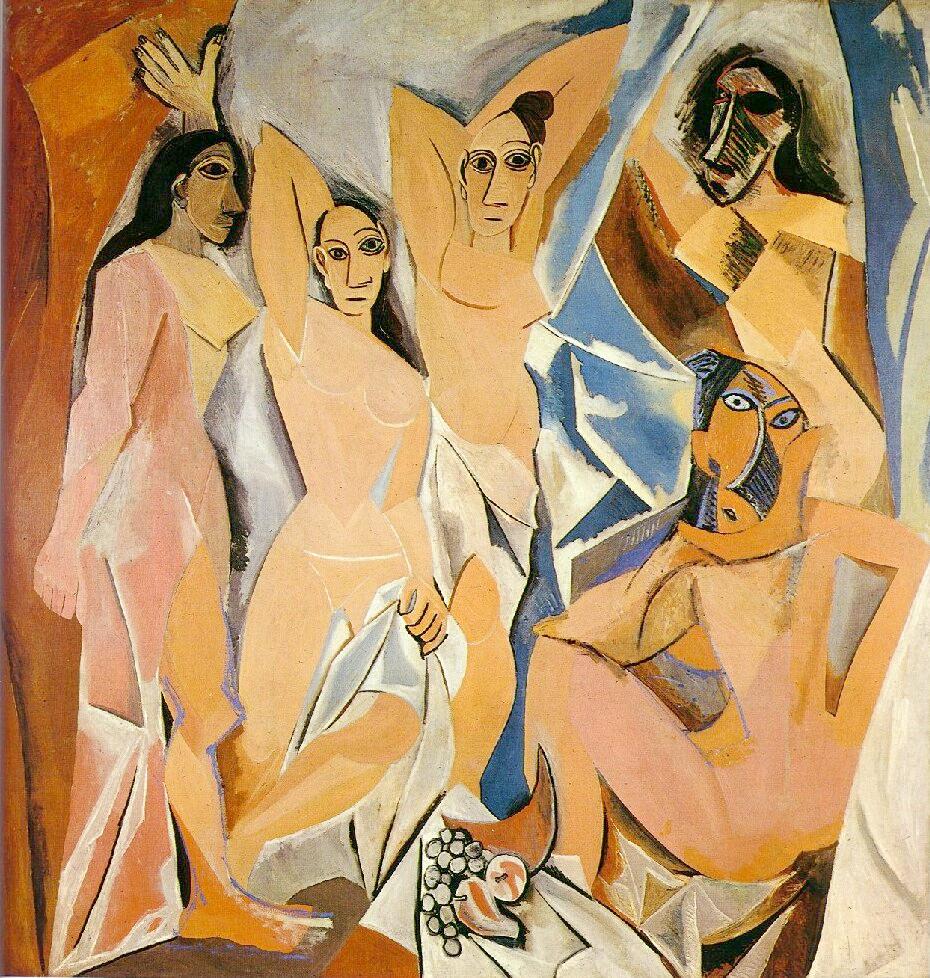

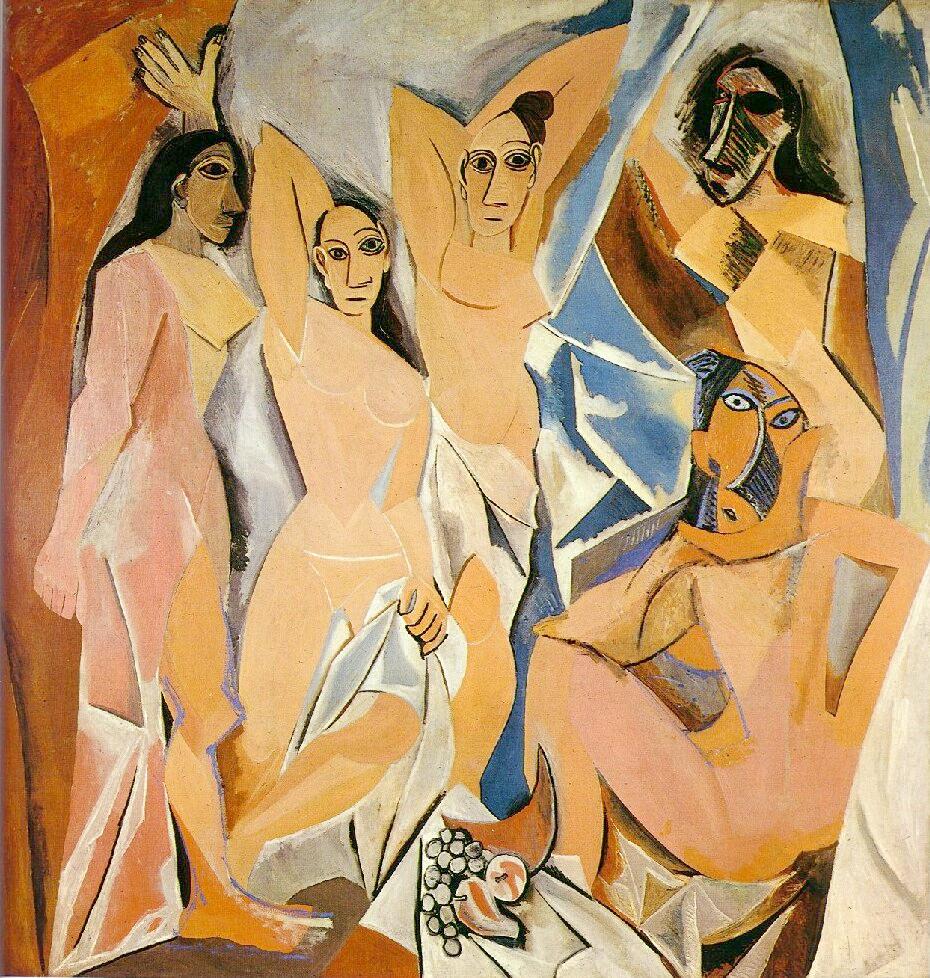

La structure de base de Serge Lutens est le triangle. Symbole s’il en fut de la trinité et du masculin-féminin selon, qu’il pointe vers le bas ou le haut, symbole aussi de la fertilité et de l’inclinaison vers le ciel ce qui faisant, donne à cet œuvre une dimension spirituelle qui est le véritable fil conducteur de l’ouvrage. Dire que Serge Lutens s’est inspiré des peintures de Picasso est une tautologie. Tout le travail respire et suinte l’admiration et l’amour du peintre. Et Serge ne s’en cache pas, au contraire, lors de l’interview, Picasso fut le point d’orgue, véritable hommage d’un artiste à un autre, pas des moindres .

Mais pourquoi Serge Lutens a-t-il éprouvé tant le besoin de structurer ses compositions et de façon quasi radicale. La réponse, vous la trouvez dans l’hétéroclité même de son œuvre. Lutens est un artiste prolixe et universel, tout jeune il débutait comme coiffeur à Lille pour venir plus tard à Paris, se faire repérer par Vogue et commencer une carrière dans la photographie de Mode. Cependant il touche à tout, maquillage, bijoux, sculptures et là, l’artiste pourrait se perdre, pour ne jamais se retrouver. Il découvre alors le Japon et c’est pour lui le choc. Comme il l’explique pour Picasso, «tout commence à la naissance par un choc…» le pays de l’extrême orient lui ouvre les yeux sur le concept de perfection, de simplicité, d’élégance. Puis il s’intéresse aux années vingt et comprend mieux que quiconque la nécessité de structurer la Mode polymorphe.

Il y a dans l’œuvre du maître tel un Huysmans (Rebours) de la Mode, un va et vient permanent entre matières complexes, coiffure, maquillage, fard à paupières, poudre blanche pour la peau et la nécessaire simplicité d’un espace structuré. Il s’agit d’un enjeu majeur, celui de la mémoire. On se souvient de ce qui est simple, alors même que la Mode met en scène des formes infinies, des matières chamarrées et disparates. Se souvenir d’une robe, d’une coiffure, d’un maquillage, d’une photo devient alors un défi que Serge Lutens relève avec philosophie. Tout d’abord la robe. Il n’y en a pas . Shiseido est un fabricant de cosmétique, Lutens va s’efforcer d’habiller ses mannequins par des symboles de vêtements, des raccourcis qui suggèrent plus que ne montrent. C’est là que la structure graphique intervient pour sublimer notre perception. Il n’y a pas de robe chez Lutens, pas à proprement parler. On devrait plutôt parler de costumes de théâtre, tel celui du No, il caricature le vêtement pour faire ressortir le maquillage et quand bien même ce maquillage est trop présent il intercale alors entre nos yeux et le visage angélique de ses modèles un voile pudique qui laissent à peine deviner le maquillage. Cet artifice, il va en user et abuser pour notre plaisir de chaque instant de chaque photographie.

Dès lors que l’on a compris le message qu’il cherche à passer, il nous devient évident que les moyens étaient là, à sa portée, simples et éternels. La structure, des formes graphiques simples, le trait, oblique de préférence vient rythmer ses compositions. Le triangle est un rappel permanent des symboles spirituels, qui «tirent» ses modèles photographiées vers une forme d’éternité. Le cercle plus rare et le carré presque toujours absent parce que contre nature, le vocabulaire de Lutens est radicalement simple. J’ai dit religieux, mais pas au sens d’une religion, ni d’une éthique, plutôt comme une quète d’un au-delà du beau, du parfait. Ce flirt permanent avec la perfection il le doit sans doute à ses années où il débuta comme coiffeur à Lille, aussi bien que sa rencontre avec le Japon, mais c’est le constructivisme, ou le cubisme en peinture qui vont donner à Lutens l’occasion de parfaire sa scénographie. Regardez cette image (1 ) puis celui-là (2 ), hommage aux taureaux de Picasso, Lutens installe son modèle dans une alchimie structurée où tout est oblique et triangle. Sauf peut-être les formes féminines de la silhouette en noir sur fond rouge. Grand dieux, et heureusement, Serge Lutens ne trahit jamais la femme, au contraire il la sublime et lui donne sa vrai dimension dans un univers graphique aux formes volontairement géométriques (3 ) .

Je ne voudrais pas terminer cette visite guidée de l’«Esprit Serge Lutens» sans oublier de vous parler de son travail sur la peau. Remarquez bien que chaque modèle est volontairement maquillée à la japonaise (théatre no dont je vous parlais précédemment), c’est là un artifice des plus heureux. Car cet ambassadeur d’une des plus prestigieuses marques de cosmétiques a bien compris qu’il ne s’agit pas tant de vendre un poudrier, un pinceau à joues, que d’insuffler aux femmes qui ont le désir de sublimer leur destin quotidien un projet d’éternité. De fait S. Lutens maquille à l’outrance ses mannequins pour faire oublier leur temporalité. C’est comme s’il nous disait, vous savez, s’il n’y avait pas de maquillage, que l’on ne verrait que la peau, ce serait donc de la viande obscène, alors il cache la viande, la chair faite viande pour la faire entrer au Panthéon de la civilisation en tant que peau sociale. Je me souviens de mes lectures de Claude Levi-Strauss (Tristes Tropiques), des indiens du Brésil que nous avons eu la joie d’approcher par les expositions au Grand Palais durant l’Année du Brésil, chaque fois qu’une civilisation entre en scène, elle commence par habiller-maquiller la peau. Cela procède de la nécessité de structurer notre être social tout comme le regard de l’Autre sur nous même. Toujours la mémoire. Et puis vous l’aurez compris, l’œuvre de Serge Lutens parle des lettres et de la typographie en filigrane de ses mises en scène. Cela ne pouvait pas me laisser indifférent. Et vous?

le déclic de la création | 100e anniversaire des Demoiselles d’Avignon | ITV Serge Lutens

Introduction publié le 8 mars 2007.

En attendant de dérusher complètement l’ITV de Serge Lutens et d’ailleurs d’y ajouter quelques éléments visuels et sonores qui manquent encore, voici un court extrait de cette rencontre magique. Où Serge nous interpelle sur le choc de la création, le déclic qui nous meut chacun en soi. Le sien, mais aussi celui de Picasso ou Van Gogh qui court toute sa vie après une certaine lumière. Et brusquement Serge s’enflamme et nous parle de ce tableau des *Demoiselles d’Avignon* qui a cent ans cette année, et qui fut oubliée, tournée contre le mur de l’Atelier du maître pendant sept ans. Pour finir par être achetée par un américain pour la somme dérisoire de 10.000F… ¶

Et tout l’œuvre de Serge Lutens sera un aller retour de ces influences, ceux d’abord de sa jeunesse, tout simplement, mais influences majeures tout de même. Picasso… le Bauhaus, l’Avant-Garde Russe… ce n’est pas rien dans le berceau d’un homme qui aurait pu ne pas venir au monde du tout…

Première partie de l’interview de Serge Lutens consacré aux Demoiselles d’Avignon et à Picasso ¶

Ingénieur du Son et Designer Interactif: Jean-Charles Baudot

introduction avec quelques portraits de l’Artiste 1 et interview place Vendôme de Serge Lutens ici 2

Rappel Juridique: toute reproduction est formellement interdite, réservé à usage strictement pédagogique !

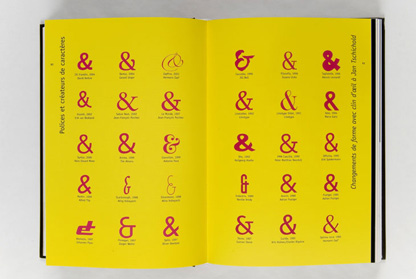

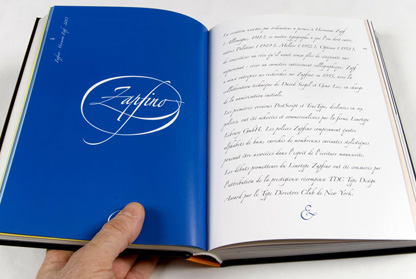

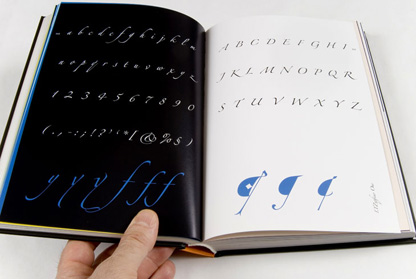

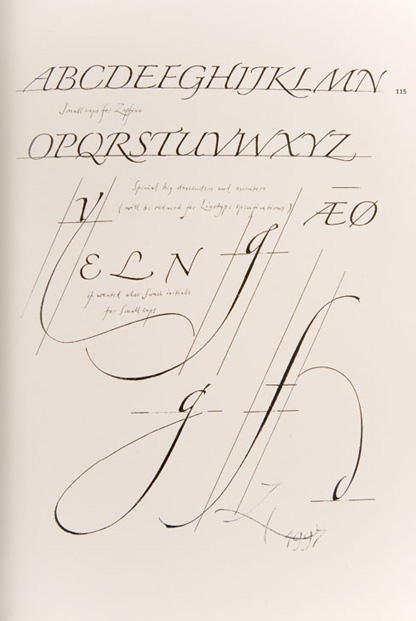

Signe de l’esperluette en Palatino italique

Signe de l’esperluette en Palatino italique Signe de l’esperluette en Palatino romain

Signe de l’esperluette en Palatino romain